简介: 传统的冷冻水系统能效已经进入瓶颈,如何利用AI提升制冷效率以及高效的利用自然冷源是值得探索的方向。

网络演进和数据业务的快速发展带动数据产业的快速发展。受到效率和成本驱动,大型数据中心的规模越来越大,但随之来的问题是消耗的电能也越来越多。

2018年全国的数据中心用电量为1608.89亿千瓦时,超过了上海市2018年全社会用电量,占中国全社会用电量的2.35%;2023年预计可达2,667.92亿千瓦时,年均增长率将达到10.64%,约等于2.5个三峡的发电量。用电问题已成为制约数据中心业务发展的瓶颈。

如果将一个典型的大型数据中心能耗进行整体分析便可以发现,破解用电瓶颈、降低数据中心能耗的关键在于提升制冷系统效率。

系统 |

IT系统 |

制冷系统 |

配电系统 |

其他 |

能耗占比 |

62% |

24% |

12% |

2% |

注:一个典型大型数据中心(PUE为1.6)的能耗系统

从上表可以看出,在非IT的能耗中,约有63%的损耗是制冷系统造成的。

如何有效的提高制冷系统效率?常见的做法包括:

1、部署高效的制冷系统,如变频冷水机组、变频冷却水泵、EC风机等;

2、利用软件、AI算法等进行制冷系统效率优化;

3、利用自然冷源,如氟泵、板式换热器、间接蒸发冷却等;

传统的冷冻水系统能效已经进入瓶颈,如何利用AI提升制冷效率以及高效的利用自然冷源是值得探索的方向。比如

1、华为的iCooling@AI能效优化技术,利用AI算法实现系统级节能,实测有效降低PUE约8%;

2、在高效利用自然冷源方面,华为选择间接蒸发冷却技术。

目前多家互联网巨头在自建的数据中心也在充分利用自然冷源,不仅年PUE均达到1.2以下,节省了成本,而且缩短了交付工期。

与传统制冷方案和其他自然冷却方案相比,间接蒸发冷却解决方案有着明显的优势:

1、自然冷源利用效率高

以北京地区为例,如采用间接蒸发冷却,每年自然冷却时长6342h,比板换(冷冻水水温15-22℃)方案多1000小时。

2、换热链路短,高效换热

水冷冷冻水方案通常需要4次换热,风冷方案需要2次换热,而间接蒸发冷却仅需要1次换热。

3、集成度高,环境要求简单

间接蒸发冷却是一站式解决方案,对大气和环境要求低。无需复杂的深化设计、现场管路连接等,简单高效。

更长的自然冷却时长,更短的制冷链路,以及广泛的适用性,使得间接蒸发冷却成为了绿色数据中心的首选方案。

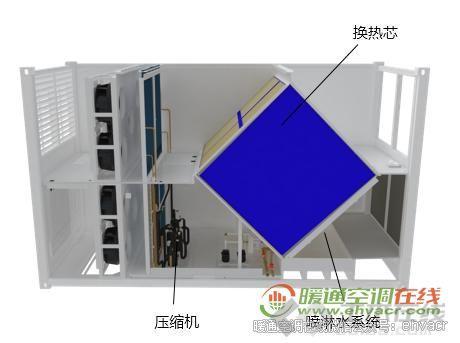

空-空换热芯、喷淋系统、压缩机补冷系统为间接蒸发冷却三大核心部件

华为基于20年全球数据中心建设、运维经验和先进的热设计技术,打造了领先的一站式间接蒸发冷却解决方案FusionCol。FusionCol突破了时间和空间的限制,实现了制冷系统的“风进水退”。

1、硬件层面:FusionCol采用高效换热芯/风机,提升机组内部效率。十字交叉流强化换热风道+矩阵式顺风喷淋设计,大幅提升了换热效率。

2、软件层面:FusionCol利用AI加持的iCooling能效优化技术,系统寻优降pPUE(partial power usage effectiveness)。机组内寻优,实现单机组高效工作;群组寻优,与室外气温、IT复杂率联动,实现制冷系统高效运行;水电平衡,节水节电模式智能推荐,实现运行成本整体最优。

以北京某数据中心(10MW规模)为例,采用FusionCol方案,PUE相比冷冻水可下降0.2,制冷系统年省电费413万。

此外,FusionCol采用极简设计,相比传统冷冻水系统减少了大量的管路施工及调试工作,缩短了50%以上的现场部署时间,业务实现了提前上线;极简的设计也大幅降低了运维难度。

2019年华为在内蒙古乌兰察布市建设多个密度为8kW/柜规模的大型数据中心,以支撑云服务业务发展。这些大型数据中心制冷系统采用FusionCol间接蒸发冷却解决方案,配合其他预制部件,15天所有设备进场,4个月完成全部安装工作,业务上线时间缩短60%。全年平均PUE低至1.15,对比传统的建设模式,至少节约45%的电力消耗,使得乌兰察布云成为了国内绿色数据中心的新标杆。

申明:本文章内容来自( 暖通空调在线),作者(华为)。著作权归原作者所有,如涉及作品侵权问题,请与我们联系,我们将及时处理!- 标签

- 冷冻冷藏